Un rastreador web, también denominado araña o crawler, es una tecnología de base en forma de un robot para la indexación de contenidos en aplicaciones web. Algunos ejemplos son la indexación web realizada por los motores de búsqueda o el escaneo y explotación de vulnerabilidades por parte de una herramienta de pruebas de seguridad.

Los rastreadores de los motores de búsqueda no suelen rastrear las páginas protegidas con contraseña, que naturalmente se consideran información privada. Por otro lado, las pruebas de seguridad realizan rutinariamente escaneos de vulnerabilidad de los sitios protegidos por contraseña como legítimos. Los escáneres de vulnerabilidad eficaces requieren una tecnología de rastreo más inteligente que pueda eludir los inicios de sesión en la web para examinar tanto las páginas públicas como las privadas. Además de las credenciales de inicio de sesión del usuario, los requisitos de inicio de sesión basados en la web de hoy en día también incluyen un CAPTCHA.

Para cumplir con los requisitos actuales de seguridad web, la versión 3.3 de RidgeBot se ha mejorado con una tecnología de rastreo inteligente que puede eludir eficazmente los requisitos actuales de acceso a la web sin tener que instalar ningún agente. Una vez que RidgeBot obtiene acceso a la página web protegida,

recuerda la información de la sesión y la utiliza para su posterior exploración y explotación. Para ver cómo lo hace, programe una demostración con nosotros.

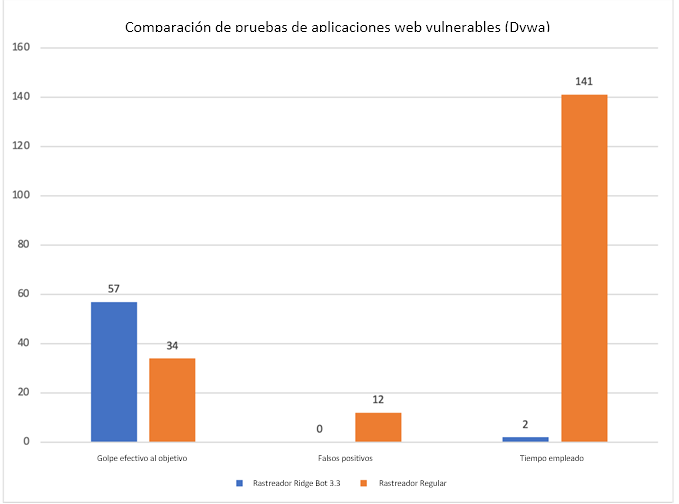

Con la tecnología RidgeBot Smart Crawling, RidgeBot puede descubrir muchas más superficies de ataque y mejorar la eficacia general de las pruebas de vulnerabilidad. Y la prueba está en el resultado: en una prueba de referencia realizada contra Damn Vulnerable Web Application (Dvwa), el rastreador RidgeBot 3.3 logró un 70% más de descubrimiento de superficies de ataque, eliminó los falsos positivos y redujo el tiempo de rastreo de 140 minutos a 2 minutos – 70 veces más rápido que un rastreador normal (veamos el siguiente gráfico).